Erste Erkenntnisse schon in den 70ern

Doch warum gibt es Hatespeech?

Haben Sie schon einmal einen Hasskommentar geschrieben? Auch nicht als Jugendsünde?

„Wir alle sind fähig, andere zu hassen. Also ich kenne keinen Menschen, die oder der nicht irgendwo in der Entwicklung Hass gegen andere gespürt oder vermutet hat.“

Konfliktforscher Andreas Zick im Interview mit MDR Wissen [2]

Manchmal kochen die Emotionen über, aber es gibt dennoch Unterschiede zwischen Menschen, die in ihrer Jugend einen Hasskommentar geschrieben haben und denen, die wesentlich älter sind und ihren Hass im Netz teilen. Im Interview mit MDR Wissen sagt Neurowissenschaftler Joachim Bauer, dass der Auslöser für Hatespeech fast immer psychischer Schmerz sei. Dieser entsteht bei Ausgrenzung, Enttäuschung oder Verletzungen. Der Neurowissenschaftler sieht zwei Möglichkeiten im Umgang mit diesen Erfahrungen:

- Den Schmerz in sich reinfressen

ODER - Wut bekommen.

„Das [Wut bekommen] ist sogar die gesündere Reaktion. Das heißt, wenn ich spüre, ich werde ausgegrenzt, man schließt mich aus, man verachtet mich, dann kann man auch eine Wut kriegen. Und aus dieser Wut heraus kann sich Hass entwickeln.“

Aber nur weil jemand mal eine Enttäuschung im Leben erfahren hat wird man:frau nicht automatisch zu einem hasserfüllten Menschen. Hassen oder nicht hassen hängt stark von unserem Umfeld ab:

„Der Hass basiert auf Feindbildern und Vorurteilen. Die bekomme ich aus meinem sozialen Kontext. Das heißt, wenn sie in einen hassenden sozialen Kontext kommen, ist die Wahrscheinlichkeit sofort höher, dass sie sich dem anschließen, weil: Hass erzeugt Zugehörigkeit zu Gruppen.“

Der Mensch ist und bleibt ein soziales Wesen. Wir suchen nach Zugehörigkeit. Gruppen grenzen sich immer ab. So richtet sich der Hass oft gegen andere Gruppen: Menschen mit Migrationshintergrund, Politiker:innen und so weiter und so fort. Der Hass gegen diese Gruppen hat eine Funktion:

Man möchte die anderen entwürdigen. Das heißt, Hass erzeugt und stärkt das Motiv, Einfluss zu nehmen und Kontrolle auszuüben. Eine Hass-Äußerung ist auch immer ein Ausdruck von: ‚Ich bin machtvoll, ich habe Kontrolle‘.

Nach der Theorie von Psychologin Anne Otto hat Hass viel mit Selbstbestätigung zu tun. Indem Mensch andere diskriminiert, fühlt Mensch sich selber besser. Und dann erhält Mensch bestätigende Kommentare oder Likes von Gleichgesinnten. Und das macht Hass verlockend. Anne Otto meint, dass normalerweise Ärger, Hass, Wut oder ähnliches durch andere Kontrollmechanismen geschützt sind, doch im Netz darf Mensch diese Aggression zeigen. [6]

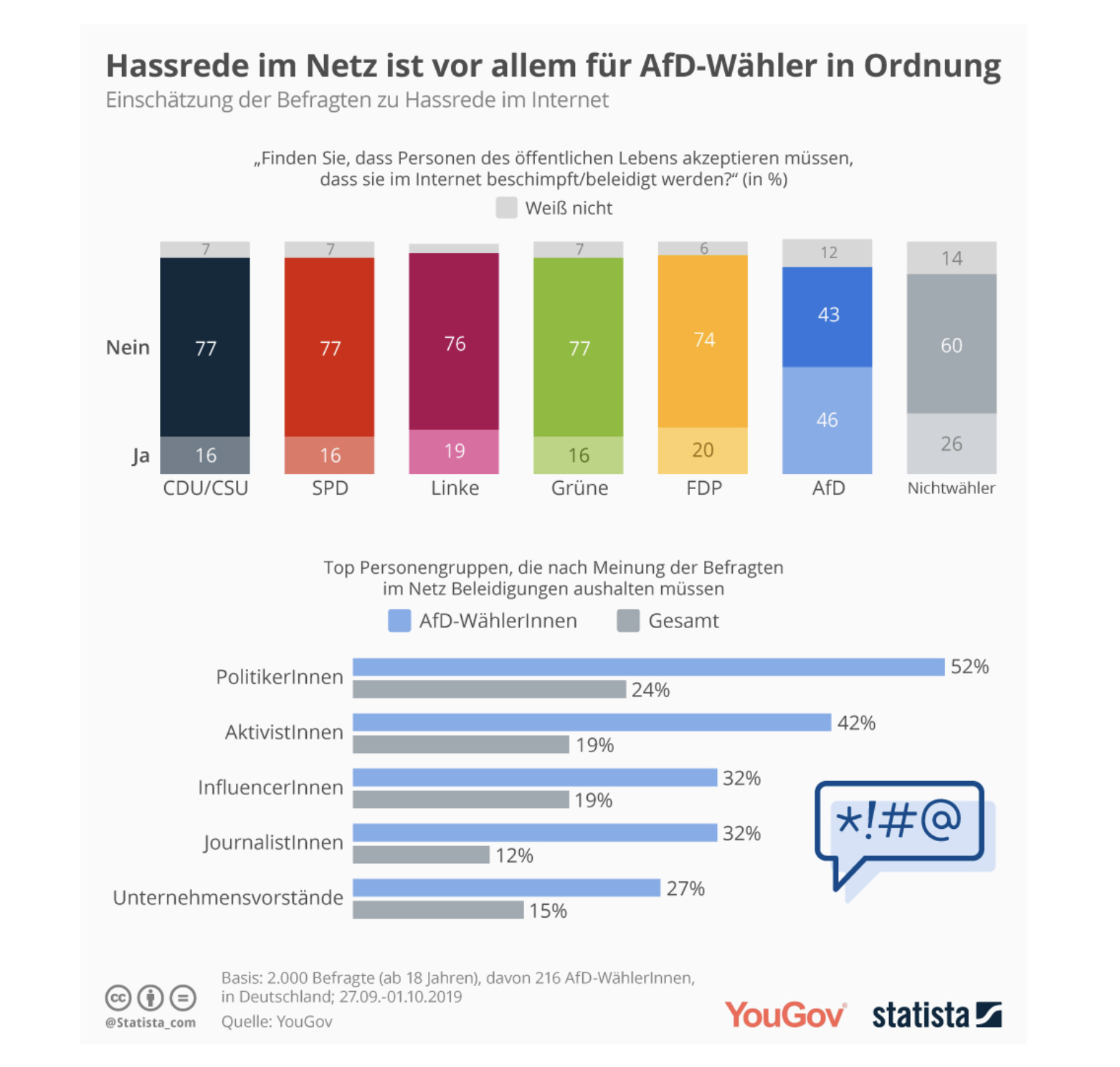

statista.de und YouGov fragten sich: Wer findet eigentlich Hassrede ok? [7] In der Grafik ist zu erkennen, dass vor allem AfD-Wähler:innen Hassrede im Netz in Ordnung finden. Außerdem müssen besonders Aktivist:innen und Politiker:innen Hatespeech aushalten.

Und jetzt? Die Rolle von Social Media

Regulieren oder nicht?

Medienkulturwissenschaftler Professor Dr. Stephan Packard sieht die Regulierung als keine einfache Entscheidung [10a]:

„Wenn sie bestimmte NutzerInnen, Inhalte oder Verwendungen ganz oder teilweise ausschließen, unterbinden sie damit Teile einer mündigen Teilhabe an der Demokratie. Wenn sie andererseits schädliche Rede, etwa propagandistische Hetzrede oder Lügenkampagnen zulassen, ist dieser auf anderem Wege kaum mehr beizukommen.“

Prof. Dr. Stephan Packard [10b]

Regulierung sei ein gefährliches Werkzeug, aber die Kontrolle über die sozialen Medien sollte auch nicht an diejenigen gehen, „die andere am besten niederschreien, einschüchtern, desinformieren oder vertreiben können“. Packard findet, dass diese dringende Frage in der Öffentlichkeit diskutiert und von der Politik entschieden werden sollte. Packard nimmt den Plattformen die Rolle als Hauptverantwortliche, denn er sagt:

„Wir dürfen die Entscheidungen mittelfristig nicht den einzelnen Plattformbetreibenden überlassen – erst recht nicht, wenn die Delegation dieser Entscheidung die Plattformen eher motiviert, zu viel als zu wenig zu sperren, weil sie etwa nur für eine unterlassene, nicht aber für eine unnötige, Sperrung Strafe zu erwarten haben.“

Prof. Dr. Stephan Packard [10c]

Die privaten Betreiber sind nicht kompetent, noch demokratisch dafür bestimmt, solche Entscheidungen im Alleingang zu treffen. Eine Antwort kann nur ein gesellschaftlicher, politisch erstrittener Konsens geben.

Daher sieht Packard zwei Aufgaben für die Debatte und die Politik [10d]:

- Entwicklung klarer und möglichst eindeutig umsetzbarer Vorgaben für Plattformen

- Entstehung einer öffentlichen Alternative zu den privaten Netzwerkbetreibenden, wie z.B. der öffentliche Rundfunk

Bereits verboten

Im Oktober 2017 trat in Deutschland das so genannte Netzwerkdurchsetzungsgesetz (NetzDG) in Kraft. „Das Gesetz zielt darauf, Hasskriminalität, strafbare Falschnachrichten und andere strafbare Inhalte auf den Plattformen sozialer Netzwerke wirksamer zu bekämpfen“, heißt es auf der Website des Bundesministerium der Justiz und für Verbraucherschutz. Das Gesetz verpflichtet die Plattformen sozialer Netzwerke dazu, „offensichtlich strafbare Inhalte“ binnen 24 Stunden nach Eingang einer Beschwerde zu löschen.

Weiterhin ist nach deutschem Recht verboten (Auswahl):

Es gibt also bereits rechtliche Rahmenbedingungen und Gesetze. Dennoch hängen wir bei der Bekämpfung hinterher. Warum? Aufgrund der schieren Anzahl der Hasskommentare.

Andere unangemessene Inhalte

Es ist mir wichtig auch auf andere Probleme im Internet hinzuweisen. Darunter zählt unter anderem der mangelhafte Jugendschutz in den sozialen Netzwerken.

Beispiel TikTok

TikTok schreibt in seinen AGB ein Mindestalter von 13 Jahren vor. Für Jugendliche unter 18 Jahren setzt die App in ihren AGB zudem explizit eine Einverständniserklärung der Erziehungsberechtigten voraus. Das Alter und die Einverständniserklärung werden jedoch nicht geprüft. Es genügt die Angabe eines [falschen] Geburtsdatums. Wenn Kinder bei der Erstellung des Profils eine falsche Angabe gemacht haben, kann es vorkommen, dass ihre Profile direkt öffentlich sind. Ansonsten wären die Profile standardmäßig privat für unter 16-Jährige. [11]

Gerade junge Menschen können oft nicht objektiv mit den dargestellten Inhalten und Schönheitsidealen umgehen. Gerade Medien verzerren Körperbilder durch Körperkulturen, Schönheitsideale und Co. (Mehr dazu auf schau-hin.info)

TikTok ist aber nicht inaktiv, was den Jugendschutz angeht. Das Unternehmen ergreift immer wieder Maßnahmen gegen den Missbrauch der Videos und die Belästigung der Nutzer:innen.

- Sperrung bestimmter Hashtags die als jugendgefährdend gelten

- Sperrung der Direktnachrichten-Funktionen für Jugendliche unter 16 Jahren, um Belästigungen einzuschränken.

- Erweiterung des Begleiteten Modus

Doch nicht nur TikTok hat Verbesserungsbedarf: YouTube und Instagram müssen nachbessern. Ganz oft hängt es mit Influencer:innen zusammen. Durch die scheinbare Nähe motivieren die Influencer:innen ihre Zuschauer:innen Dinge zu konsumieren, die sie oft selber nicht einmal getestet haben.

Gesammelte Lösungsversuche

Die Entscheidung, welche Inhalte auf riesigen Kommunikationsplattformen gelöscht werden, sollte von Politik und Gesellschaft getroffen werden. Allein die Durchsetzung der Regeln würde dann den Plattformen unterliegen.

„Das Netz braucht demokratische Kontrolle, keine absolutistischen Alleinherrscher“, schreiben die Journalisten Simon Hurtz und Martin Fehrensen im „Social Media Watchblog“.

Es gibt viele Ansätze und Ideen – auch jenseits von Gesetzen. Von Plattformräten, Warnhinweisen oder transparente Content-Moderation nach den sogenannten Santa Clara Principles. [12]

Fazit

Es ist unbestreitbar: Medien besitzen einen immensen Einfluss auf uns. Das Internet ist ein gesellschaftlicher Raum. Daher ist es wichtig, dass sich Plattformen für ein soziales Miteinander einsetzen, nach vorgegeben Regeln der Gesellschaft. Auch die Gesellschaft ist verpflichtet, achtsamer zu werden, was auf den Social Media Kanälen passiert. Es gibt viele Krisenherde im Internet und sie sollten bekämpft werden.

Das ist alles möglich. Die Frage ist nicht mehr, ob die Plattformen Verantwortung übernehmen, sondern wann. Gemeinsam können wir das Netz zu einem besseren Ort machen, ohne Hass und Desinformationen.

Quellen:

[1] Landesmedienzentrum Baden-Württemberg: „HATESPEECH – HASS IM NETZ“

[2]-[6] MDR.de: „HATE SPEECH: WAS DAHINTER STECKT“; vom 12.06.2020

[7] Yougov.de: „Hassrede im Netz ist vor allem für AfD-Wähler kein No-Go“

[8] FAZ: „61 Jahre alter Mann gesteht Hasskommentare auf Facebook“, vom 18.02.2021

[12] Deutschlandfunk.de: „Hass im Netz: Soziale Netzwerke nach dem Sturm aufs Kapitol“

Zum Weiterlesen:

- Medienpolitik.net: „Soziale Netzwerke und Plattformen stärker in die Verantwortung nehmen

- Universität zu Köln: „Expertenstatements: Medienmacht und Verantwortung von Social Media Plattformen.“

- Studie der Medienanstalt NRW: Befragung zur Wahrnehmung von Hassrede

- Politik-digital-de: „Social Media Week: Was bedeutet Verantwortung im Internet

- Zeit.de: „Löschstatus – es ist kompliziert“

- No-hate-speech.de

Organisationen, die Hilfe anbieten und sich für eine bessere Diskussionskulturen engagieren:

- NummergegenKummer

- #Dabei – Gegen Hass im Netz

- Juuuport.de

- Ichbinhier.eu

- Bündnis gegen Cybermobbing

- Scroller – Das Medienmagazin für Kinder

- ZDK – Gesellschaft Demokratische Kultur GmbH

Sie wollen mehr zum Thema Social Media erfahren? Das Seminar „Social Media Manager:in (BVCM)“ könnte Sie interessieren.